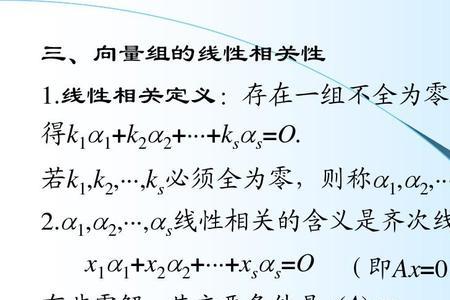

一般来讲当样本数大于数据维度时,矩阵可逆,可以采用最小二乘法求得目标函数的闭式解。当数据维度大于样本数时,矩阵线性相关,不可逆。此时最小化目标函数解不唯一,且非常多,出于这样一种情况,我们可以考虑奥卡姆剃刀准则来简化模型复杂度,使其不必要的特征对应的 [公式] 为0,可以考虑[公式] 范数使得模型中 [公式] 非0个数最少(实际上采用的是 [公式] 范数的一个凸近似)。

当然,岭回归,lasso回归的最根本的目的不是解决不可逆问题,而是防止过拟合。

原创 | 2022-12-05 17:14:10 |浏览:1.6万

一般来讲当样本数大于数据维度时,矩阵可逆,可以采用最小二乘法求得目标函数的闭式解。当数据维度大于样本数时,矩阵线性相关,不可逆。此时最小化目标函数解不唯一,且非常多,出于这样一种情况,我们可以考虑奥卡姆剃刀准则来简化模型复杂度,使其不必要的特征对应的 [公式] 为0,可以考虑[公式] 范数使得模型中 [公式] 非0个数最少(实际上采用的是 [公式] 范数的一个凸近似)。

当然,岭回归,lasso回归的最根本的目的不是解决不可逆问题,而是防止过拟合。

Copyright 2005-2020 www.kxting.com 版权所有 |  湘ICP备2023022655号

湘ICP备2023022655号

声明: 本站所有内容均只可用于学习参考,信息与图片素材来源于互联网,如内容侵权与违规,请与本站联系,将在三个工作日内处理,联系邮箱:47085,1089@qq.com